我的深度学习毕业论文血泪史,从入门到头发稀疏的终极指南

- AI文章

- 2025-04-08 07:02:20

- 30

** ,本文回顾了我撰写深度学习毕业论文的曲折历程,堪称一部从学术小白到“发量告急”的实战血泪史,从最初被神经网络、反向传播等概念“劝退”,到熬夜调参、Debug模型崩溃的日常,再到面对数据集偏差、过拟合等问题的灵魂拷问,每一步都充满挑战,文中总结了关键教训:**“不要迷信论文复现”**(环境差异可能让你怀疑人生)、**“早跑实验,留足缓冲期”**(GPU排队比食堂抢饭还激烈),以及**“可视化工具是救命稻草”**(TensorBoard能让你少掉50%头发),尽管过程堪比“学术渡劫”,但突破瓶颈后的成就感让一切值得,本文旨在为后来者提供一份接地气的避坑指南,附带友情提示:**护发素和咖啡请提前囤货。** (字数:198)

写深度学习毕业论文这件事,说多了都是泪,从选题时的雄心壮志,到跑代码时的怀疑人生,再到答辩前的彻夜改稿——如果你也正在经历这些,恭喜你,你并不孤单,我就来聊聊这段“痛并快乐着”的旅程,顺便给后来人挖几个坑(划掉)指几条明路。

选题:你以为的“创新”和导师眼中的“常识”

一开始,我信心满满地列了十几个选题,基于深度学习的猫狗情绪识别”(导师:“这年头连猫狗都有心理健康问题了?”),或者“用Transformer预测明天食堂的菜价”(导师:“你不如先预测一下自己能不能毕业”),在导师的“温柔点拨”下,我选了一个看起来既不天马行空又不至于被前人研究榨干的题目。

血泪建议:选题别太飘,但也别太怂,先扒拉几篇顶会论文,看看大佬们在卷什么方向,再找个缝钻进去,基于轻量化模型的实时XX检测”就比“颠覆性AI框架”靠谱得多。

数据:你以为的“公开数据集”和实际的“脏活累活”

理想中:下载现成数据集,import torch,一键跑出99%准确率。

现实中:数据缺失、标注错误、类别不平衡……我甚至手动标注了2000张图片,练就了一双“像素级找茬”的钛合金狗眼。

偷懒技巧:Kaggle、UCI、Google Dataset Search是你的好朋友,如果必须自己标注,试试用半监督学习(比如伪标签)或者众包平台(但小心预算爆炸)。

调参:玄学中的玄学

“为什么别人的ResNet轻松收敛,我的模型却像个叛逆期的孩子?”——这是我在实验室嚎过的原话,调参那段时间,我深刻理解了“深度学习”的“深度”可能指的是“深夜改参数”的“深度”。

玄学指南:

- 学习率:别头铁用默认值,试试余弦退火或OneCycleLR。

- Batch Size:显存不够就梯度累积,别和硬件硬刚。

- 早停法(Early Stopping):拯救过无数濒临崩溃的研究生。

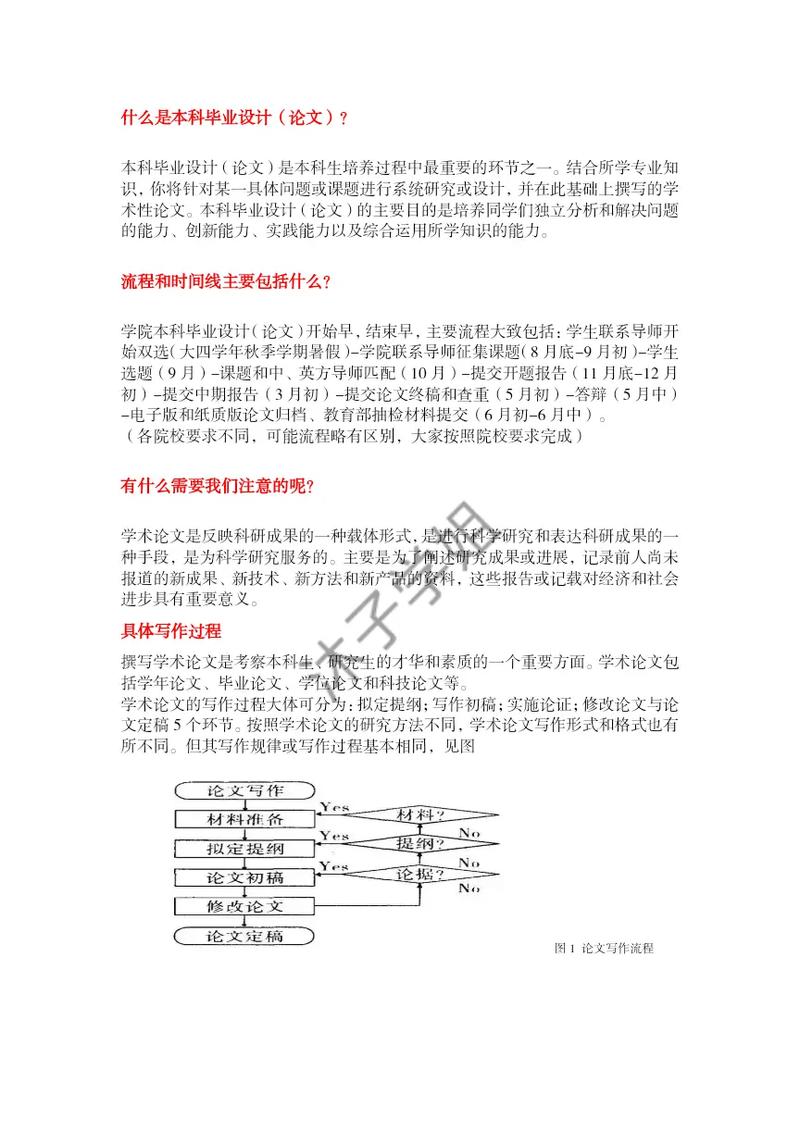

写作:从“学术垃圾”到“勉强能看”

初稿写完给导师看,导师的批注比正文还长:“这里像谷歌翻译的”“这段引用是来凑字数的吗?”……后来我悟了:论文写作的核心是——说人话。

求生技巧:

- 多用流程图、表格和对比实验图(导师和审稿人都爱看图说话)。

- 引言部分先讲“为什么重要”,再讲“别人干了啥”,最后甩出“但我更牛”。

- 讨论部分诚实点,别把“结果不显著”写成“未来研究方向”。

答辩:如何优雅地糊弄不会的问题

答辩现场,评委问:“你的模型在极端情况下为什么失效?”我(内心OS:因为我也没试过啊)表面淡定:“感谢您的提问,这确实是本工作的局限之一,我们计划在后续研究中引入对抗训练……”——万能话术,亲测有效。

毕业只是开始

写完论文才发现,深度学习的坑根本填不完:部署要学Docker,落地要懂业务逻辑,面试还可能被问“手写反向传播”……但回头看看,这段经历最大的收获不是那张毕业证,而是“给我一堆bug,我能还你一个workaround”的硬核心态。

如果你正在写深度学习毕业论文,头发会掉,代码会崩,但最后你一定会笑着(或哭着)说:“我居然搞定了!”

(注:本文灵感来源于真实事件,如有雷同,说明你也经历过被PyTorch支配的恐惧。)

本文由ailunwenwanzi于2025-04-08发表在论改改,如有疑问,请联系我们。

本文链接:http://www.huixiemao.cn/ai/668.html